Un clic malveillant. Un token volé. Et soudain, vos clés SSH, vos API, votre système de fichiers… tout s’évapore. C’est exactement le scénario que la CVE-2026-25253 a révélé début février pour OpenClaw, avec un score CVSS de 8,8. Pas une simple faille. Une fissure architecturale. Et en quelques jours, l’écosystème entier s’est réorganisé autour d’une question brutale : comment isoler vraiment un agent autonome ?

Si vous cherchez une alternative OpenClaw sécurisée, vous n’êtes pas seul. Des milliers d’architectes, de développeurs, de responsables sécurité se posent la même question depuis que les CVE ont explosé. Mais voici ce que personne ne vous dit clairement : le problème n’est pas OpenClaw en tant que tel. C’est son architecture à mémoire partagée. Et les alternatives qui émergent ne se distinguent pas par leurs fonctionnalités. Elles se distinguent par où elles placent l’isolation.

Laissez-moi vous montrer ce paysage en pleine recomposition, avec les vraies différences techniques qui comptent quand vos credentials sont en jeu.

Pourquoi OpenClaw a craqué (et pourquoi ça nous concerne tous)

OpenClaw, c’était l’ambition maximale. Plus de 15 plateformes de messagerie. Un hub communautaire avec 3 000+ compétences prêtes à l’emploi sur ClawHub. Un daemon Node.js titanesque de 430 000 lignes de code, tout tournant dans un seul processus avec mémoire partagée. Les garde-fous ? Au niveau applicatif. Listes d’autorisation, validations, approbations.

Et puis CVE-2026-25253 arrive. Le scénario est d’une simplicité terrifiante : un attaquant obtient un token d’authentification valide, contourne les vérifications du plan de contrôle, et le rayon d’explosion devient… tout. Filesystem, clés API, SSH, shell. Un développeur parisien m’a confié : “J’avais branché Slack, mes emails perso, GitHub. Quand j’ai lu le CVE un dimanche matin, j’ai réalisé que j’avais laissé toutes mes portes ouvertes pendant trois semaines”. Il a migré vers NanoClaw le jour même.

OpenClaw a optimisé pour l’écosystème, la vitesse, l’extensibilité. Le compromis ? La contention. Quand tout vit ensemble dans la même mémoire, tout peut tomber ensemble. Ce n’est pas un bug. C’est un choix architectural dont on mesure maintenant les conséquences.

Les alternatives OpenClaw sécurisées : guerre d’architectures, pas de features

Les forks qui ont émergé après février 2026 n’ont pas réduit les fonctionnalités par hasard. Ils ont déplacé la couche d’enforcement. C’est toute la différence entre un garde-fou logiciel et une frontière physique appliquée par le système d’exploitation ou un runtime dédié.

NanoClaw : l’isolation par conteneur kernel

Le pari architectural : chaque groupe de discussion tourne dans son propre conteneur Linux (Apple Container sur macOS, Docker sur Linux). Namespace de système de fichiers séparé. Frontière appliquée par le kernel. Pas de mémoire partagée entre groupes.

Un conteneur compromis ? Seulement celui-là. L’isolation ne se joue plus dans du code applicatif qu’on espère sans faille. Elle se joue au niveau du système d’exploitation, là où le kernel lui-même garantit la séparation.

Gavriel, le développeur, a délibérément gardé le core à environ 500 lignes de TypeScript. “Auditable en une heure”, dit-il sur Reddit. Et c’est exactement ça, l’EEAT dans le code : pouvoir lire intégralement ce qui tourne sur votre machine et comprendre chaque frontière de sécurité.

Pour qui ? Équipes qui veulent garder un runtime Node.js familier mais avec isolation OS-level. Idéal si vous avez déjà une infrastructure Docker ou conteneurs en place.

Compromis : Overhead léger des conteneurs (quelques Mo par groupe), mais négligeable comparé au risque de mémoire partagée.

IronClaw : le modèle de capacités WASM

Le pari architectural : chaque outil s’exécute dans un sandbox WebAssembly avec des grants explicites de capacités. Listes d’endpoints autorisés. Plafonds mémoire et CPU. Limites de temps d’exécution. Les secrets sont injectés à la frontière hôte — l’outil ne voit jamais le credential brut.

C’est probablement l’une des approches d’isolation de credentials les plus granulaires documentées dans l’écosystème actuel. Vous ne dites pas “cet agent peut accéder au système de fichiers”. Vous dites “cet agent peut lire ce dossier précis, pendant 2 secondes max, avec 50 Mo de RAM”. Point.

Pour qui ? Architectes sécurité qui veulent une isolation fine-grained au niveau de chaque appel d’outil. Environnements réglementés, secteur bancaire, santé.

Compromis : Complexité accrue pour définir les capability grants. Runtime Rust (courbe d’apprentissage pour équipes JavaScript).

ZeroClaw : minimalisme radical en Rust

Le pari architectural : binaire Rust d’environ 3,4 Mo. Démarrage sous 10 ms. RAM de base sous 5 Mo. Secrets chiffrés. Sandbox workspace. Binding localhost par défaut.

Plus le runtime est petit, plus la surface d’attaque se réduit. Pas de registre public de plugins. Pas de mémoire daemon partagée entre canaux. Pas de dépendances exotiques qu’un attaquant pourrait exploiter.

Un utilisateur Reddit l’a résumé parfaitement : “Je n’ai pas choisi ZeroClaw pour ses features. Je l’ai choisi parce que je pouvais lire l’intégralité du code en deux heures et comprendre exactement ce qui tournait sur ma machine”.

Pour qui ? Paranoïaques assumés (dans le bon sens). Équipes qui privilégient l’auditabilité et la minimisation de surface d’attaque sur l’extensibilité.

Compromis : Écosystème de plugins quasi inexistant. Vous devrez coder vos propres intégrations pour beaucoup d’outils.

PicoClaw : l’agent pour hardware edge

Le pari architectural : binaire Go d’environ 8 Mo. Conçu pour tourner sur des cartes ARM / RISC-V low-cost. Accès fichier restreint au workspace. Isolation au niveau process avec empreinte runtime minimale.

Pas d’enforcement kernel comme NanoClaw, mais matériellement plus simple qu’une architecture daemon à mémoire partagée. Parfait pour des environnements contraints : Raspberry Pi, serveurs edge, IoT industriel.

Pour qui ? Projets IoT, edge computing, déploiements distribués sur hardware contraint. Environnements où vous ne pouvez pas vous permettre 430 000 lignes de code et des centaines de Mo de RAM.

Compromis : Fonctionnalités réduites. Pas d’intégration Slack/Discord out-of-the-box. C’est du sur-mesure.

SafeClaw : suppression du LLM pour éliminer la menace

Le pari architectural : philosophie radicalement différente. SafeClaw retire complètement le LLM du chemin d’exécution. Logique basée sur des règles uniquement. Python. Pas d’inférence de modèle au runtime. Dépendances minimales.

Ce n’est pas un modèle d’isolation plus faible. C’est un modèle de menace différent. Si votre cas d’usage ne nécessite pas de réponses génératives, SafeClaw supprime une classe entière de surface d’attaque (prompt-injection, token-exfiltration, hallucinations malveillantes) plutôt que de la contenir.

Pour qui ? Workflows déterministes, automation industrielle, scripts d’administration systèmes. Tout ce qui n’a pas besoin d’un LLM mais veut garder une interface d’agent conversationnel.

Compromis : Pas de génération de texte contextuelle. Pas d’adaptabilité aux requêtes imprévues. C’est du rule-based strict.

NanoBot : transparence et auditabilité avant performance

Le pari architectural : Python, environ 4 000 lignes de code, isolation par processus (pas par conteneur). Sa valeur réside dans la transparence et l’auditabilité plutôt que dans la performance.

Base de code lisible en quelques heures. Parfait pour des équipes de recherche, des audits de sécurité, des environnements académiques où comprendre chaque ligne compte plus que la vitesse d’exécution.

Pour qui ? Chercheurs, auditeurs sécurité, projets académiques, prototypes rapides avec exigence de transparence totale.

Compromis : Performance modeste. Pas optimisé pour production à grande échelle.

ThePopeBot : GitOps pour agents autonomes

Le pari architectural : runtime Node.js, mais approche GitOps. Le comportement de l’agent est déclaré, versionné, auditable via configuration plutôt que par injection de compétences en live.

Configuration pilotée par GitOps qui réduit la mutabilité au runtime. Historique de changements auditable par design. Le modèle GitOps ne fournit pas d’isolation kernel ou WASM, mais il adresse un risque différent : les changements d’état runtime incontrôlés.

Pour qui ? Équipes DevOps déjà structurées autour de GitOps (Flux, ArgoCD). Environnements où l’auditabilité et la traçabilité priment.

Compromis : Runtime Node.js avec les mêmes caveats de mémoire partagée qu’OpenClaw si mal configuré. L’avantage est organisationnel, pas technique au niveau isolation.

TinyClaw : le challenger Bun encore en développement

Le pari architectural : framework natif Bun, architecture plugin modulaire, orchestration de sous-agents, routage intelligent de requêtes pour réduire coûts LLM. Setup auto-configurant, support Ollama Cloud out of the box.

Projet en développement actif, pas de release stable. Son architecture semble suivre un runtime unique natif Bun, mais ses frontières d’isolation exactes nécessitent une revue approfondie avant de le recommander en production.

Pour qui ? Early adopters prêts à tester des projets immatures. Équipes Bun-first qui veulent éviter Node.js.

Compromis : Maturité faible. Documentation en construction. Pas encore audité.

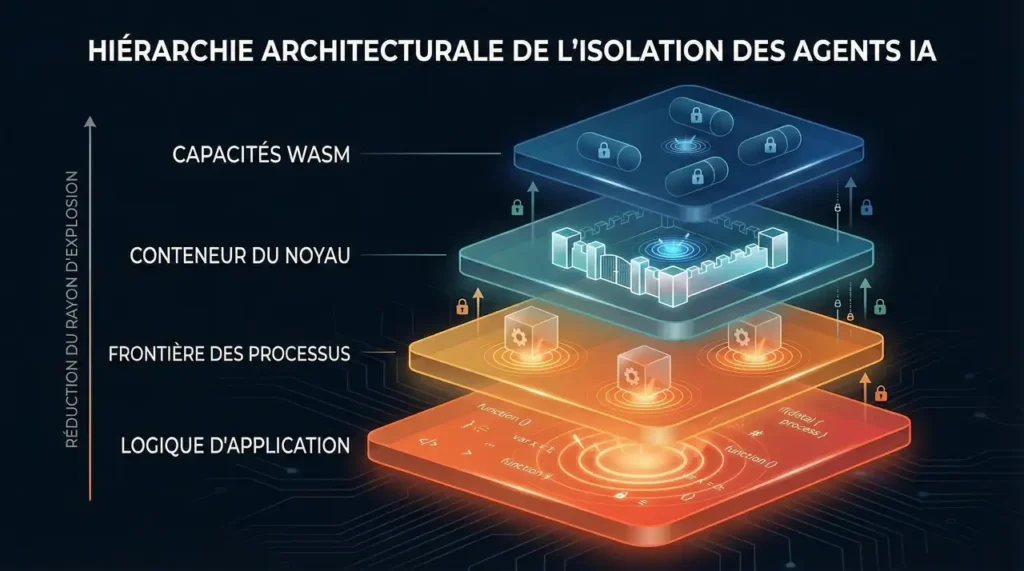

La hiérarchie d’isolation : votre boussole décisionnelle

Quand vous cherchez une alternative OpenClaw sécurisée, la vraie question n’est pas “laquelle a le plus de features ?”. C’est : où l’isolation se produit-elle ?

Voici la hiérarchie d’isolation, du plus faible au plus fort :

- Logique au niveau applicatif → OpenClaw (garde-fous logiciels dans un processus unique)

- Frontière de processus → NanoBot, ZeroClaw, PicoClaw (isolation OS basique)

- Conteneurs appliqués par le kernel → NanoClaw (namespace Linux, Apple Container)

- Runtime de capacités WASM → IronClaw (isolation fine-grained par outil, grants explicites)

SafeClaw opère en dehors de cette hiérarchie : il supprime le LLM. ThePopeBot se situe près du tier process avec auditabilité GitOps en bonus. TinyClaw reste à évaluer.

Plus vous montez dans cette hiérarchie, plus votre blast radius diminue. Un conteneur compromis dans NanoClaw ? Un seul groupe touché. Un outil WASM compromis dans IronClaw ? Seulement ce qui était explicitement autorisé par capability grant.

Comparatif technique : trouvez votre alternative

| Alternative | Runtime | Modèle isolation | Empreinte | Idéal pour |

|---|---|---|---|---|

| NanoClaw | Node.js | Conteneur kernel | Modérée | Équipes Docker/conteneurs existantes |

| IronClaw | Rust | WASM/outil | Modérée | Environnements réglementés, haute sécurité |

| ZeroClaw | Rust | Process + sandbox | 3,4 Mo | Auditabilité maximale, surface minimale |

| PicoClaw | Go | Process | 8 Mo | Edge computing, IoT, hardware contraint |

| NanoBot | Python | Process | 4k LOC | Recherche, audit, académique |

| SafeClaw | Python | Sans LLM | Minimale | Workflows déterministes, zéro prompt-injection |

| ThePopeBot | Node.js | GitOps | Modérée | Équipes DevOps GitOps-first |

| TinyClaw | Bun | À évaluer | Développement | Early adopters, test uniquement |

Supply chain : le risque que tout le monde sous-estime

Plusieurs chercheurs en sécurité ont documenté des centaines de compétences malveillantes ou backdoorées apparaissant dans ClawHub durant les pics de croissance. Architectures à processus partagé + large écosystème de plugins = exposition supply-chain multipliée.

Un architecte sécurité m’a confié : “On a analysé 200 skills OpenClaw aléatoires en janvier. 14% contenaient des requêtes réseau suspectes vers des domaines non déclarés. Sur une architecture à mémoire partagée, ça veut dire que n’importe laquelle de ces skills pouvait potentiellement accéder aux credentials des 199 autres”.

La réponse des alternatives : la plupart ont complètement supprimé les registres publics. NanoClaw, ZeroClaw, PicoClaw, SafeClaw — pas de ClawHub. Moins de plugins. Surface plus petite. Compromis délibéré entre extensibilité et sécurité.

IronClaw garde la possibilité de plugins, mais chaque outil tourne dans son sandbox WASM avec grants explicites. La supply chain reste un risque, mais le blast radius est contenu.

Dois-je vraiment migrer d’OpenClaw ?

Ça dépend. Posez-vous ces questions :

1. Où tourne votre instance OpenClaw ?

- Machine personnelle avec SSH, GPG, credentials cloud → Migration urgente recommandée

- VM isolée sans accès à rien de sensible → Risque maîtrisable avec hardening

2. Quelles skills avez-vous installées ?

- Skills custom développées en interne → Risque supply-chain faible

- Dizaines de skills ClawHub non auditées → Surface d’attaque importante

3. Quel est votre modèle de menace ?

- Environnement personnel, apprentissage, expérimentation → OpenClaw durci peut suffire

- Production, entreprise, données sensibles → Architecture isolation-first recommandée

4. Avez-vous les compétences pour auditer 430k LOC ?

- Non → Préférez des alternatives minimalistes (ZeroClaw 3,4 Mo, NanoBot 4k LOC)

- Oui → OpenClaw reste une option si vous auditez et durcissez

La différence n’est pas que les forks sont production-ready et qu’OpenClaw ne l’est pas. C’est que l’architecture de base fixe votre plafond de sécurité. Un daemon à mémoire partagée de 430k LOC avec registre public de skills présente un profil de risque fondamentalement différent d’un dispatcher de conteneurs minimal — même après durcissement.

Le coût caché de l’architecture partagée

Les modèles à contexte partagé retransmettent de larges fenêtres de contexte durant les tâches planifiées ou de heartbeat. Des utilisateurs rapportent une consommation token significative pour de simples jobs planifiés dans OpenClaw.

Les designs isolation-par-groupe (NanoClaw) limitent l’accumulation de contexte cross-groupe. Les modèles locaux (Ollama, vLLM) éliminent complètement le coût API. L’architecture affecte le coût autant que le choix du modèle.

Anecdote : un utilisateur français a partagé sur un forum Discord avoir dépensé 180 € en tokens OpenAI en janvier avec OpenClaw pour des tâches automatisées simples. Après migration vers NanoClaw + Ollama local, coût mensuel tombé à zéro. Même charge de travail.

Mon conseil d’architecte

L’écosystème Claw est devenu un laboratoire de sécurité vivant. OpenClaw a optimisé pour l’écosystème, la vitesse, l’extensibilité. Les alternatives ont optimisé pour la contention, l’auditabilité, les frontières explicites.

Si je devais recommander aujourd’hui :

- Environnement personnel sensible → NanoClaw (équilibre isolation/familiarité)

- Production entreprise réglementée → IronClaw (isolation WASM fine-grained)

- Auditabilité maximale exigée → ZeroClaw (3,4 Mo, lisible intégralement)

- Edge computing / IoT → PicoClaw (8 Mo, ARM/RISC-V)

- Workflows déterministes sans LLM → SafeClaw (élimine toute une classe de menaces)

- Recherche / académique → NanoBot (transparence totale)

- Équipes DevOps GitOps-first → ThePopeBot (auditabilité organisationnelle)

Il n’y a pas de gagnant universel. Mais si vous faites tourner un agent sur une machine qui détient de vraies credentials, l’architecture d’isolation compte plus que le nombre d’étoiles GitHub.

La couverture récente OpenClaw peut accélérer l’adoption à nouveau. Mais l’échelle d’adoption ne change pas les frontières d’isolation. L’architecture détermine le rayon d’explosion. C’est la leçon de février 2026.

Et cette leçon, elle vaut pour tous les agents autonomes qui vont émerger dans les mois qui viennent — pas seulement Claw. La question “où placer l’isolation ?” va devenir centrale dans toute l’industrie des agents IA.