L’univers de l’intelligence artificielle vient de basculer. En quelques jours seulement, quatre annonces fracassantes ont émergé simultanément. Microsoft dévoile son premier générateur d’images maison. Google intègre Nano Banana partout dans son écosystème. Un géant chinois libère un modèle colossal en open source. Et la recherche vocale se réinvente sans transcription textuelle.

Ces mutations ne relèvent pas du simple progrès technique. Elles incarnent une rupture profonde qui transformera votre manière de créer, chercher et interagir avec les machines.

Microsoft s’émancipe avec MAI-Image-1

Personne ne voyait venir ce coup d’éclat. Pendant des années, Microsoft s’est appuyé sur OpenAI pour ses outils génératifs. DALL-E alimentait ses créations visuelles. ChatGPT propulsait ses assistants conversationnels.

Puis le 13 octobre a tout changé.

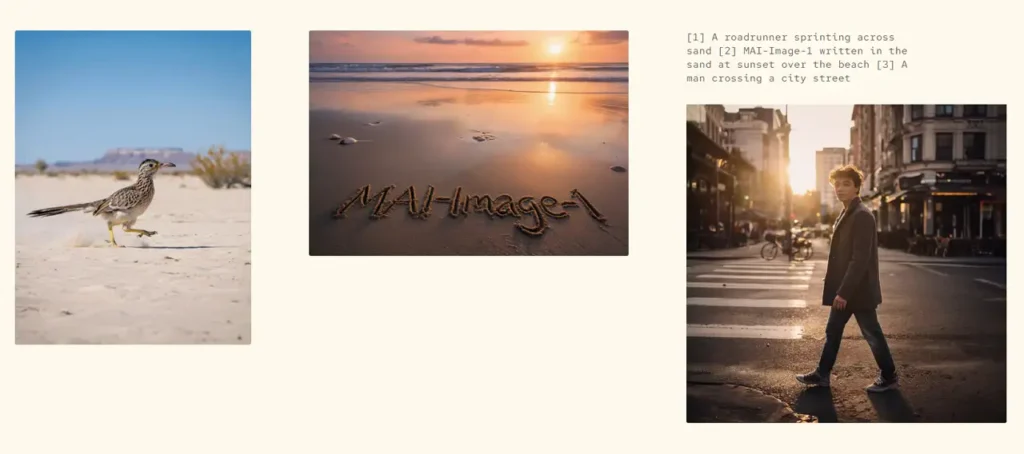

MAI-Image-1 surgit comme le premier générateur d’images conçu entièrement en interne. Pas un prototype timide — un concurrent féroce qui atteint directement la neuvième place sur LM Arena. Cette plateforme rassemble des millions d’utilisateurs évaluant la qualité des créations visuelles. Se hisser dans le top 10 dès le lancement ? Une prouesse face à Midjourney, DALL-E et autres titans établis.

Ce qui distingue vraiment MAI-Image-1 : sa philosophie esthétique.

Microsoft a collaboré avec des créateurs professionnels pour éliminer ce « look IA » stérile. Vous connaissez ces visuels trop lisses, artificiellement polis, où tout semble verni ? L’équipe voulait l’exact opposé. Un photoréalisme organique. Des images qui respirent la matière.

Imaginez un café en fin d’après-midi. Le soleil filtre à travers les vitres. Il se reflète sur les tasses en porcelaine. Des ombres subtiles dansent sur la table. Les reflets, la diffraction lumineuse, les ombres indirectes — MAI-Image-1 capture ces détails avec une minutie presque picturale.

L’enjeu stratégique derrière la technologie

Microsoft a investi des dizaines de milliards dans OpenAI. Pourtant, l’entreprise trace désormais une voie d’indépendance délibérée. MAI-Voice-1 pour la synthèse vocale. MAI-1-preview pour le texte. Maintenant MAI-Image-1 pour les visuels.

Le message implicite ? Ne jamais dépendre d’un seul partenaire.

L’intégration de modèles Anthropic dans Microsoft 365 confirme cette diversification maîtrisée. Pour vous, utilisateur final, cela signifie bientôt un accès natif dans Copilot et Bing Image Creator. Des centaines de millions de personnes pourront générer des images professionnelles sans effort additionnel ni abonnement supplémentaire.

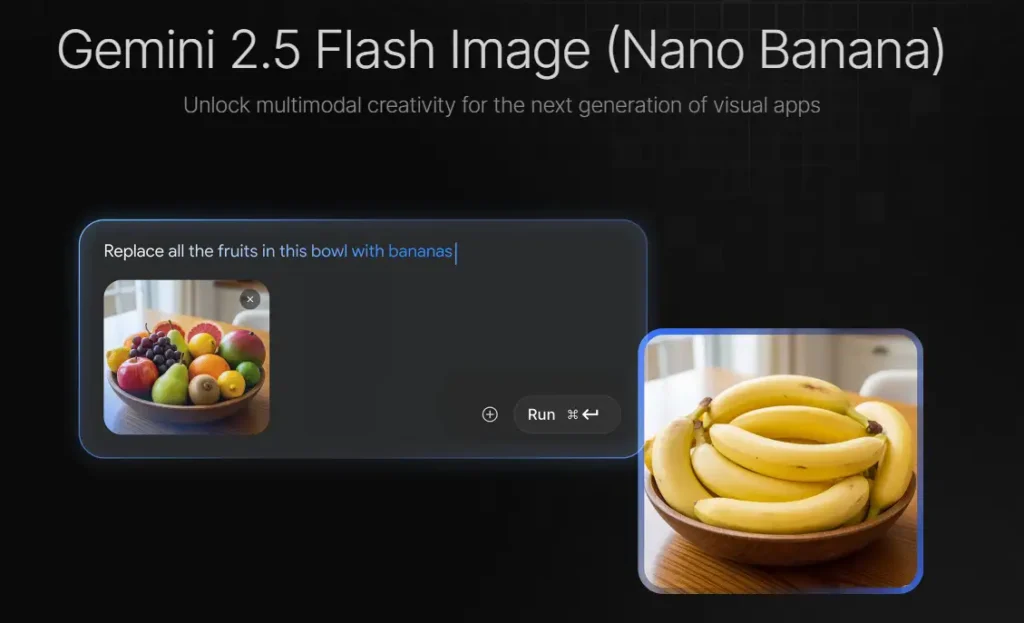

Google consolide sa domination avec Nano Banana

Le même 13 octobre, Google frappait un coup tout aussi retentissant. L’expansion de Nano Banana dans Google Search et Notebook LM marque une étape décisive. Ce surnom presque facétieux désigne le modèle Gemini 2.5 Flash Image, devenu si populaire que Google l’a adopté officiellement.

Les chiffres donnent le vertige : cinq milliards d’images générées en moins de deux mois.

Désormais, Google Lens arbore un nouveau bouton orné d’une petite banane jaune. Derrière cette icône anodine se cache une révolution silencieuse. Depuis l’interface de recherche, vous pouvez instantanément générer ou modifier des images.

Quelques exemples concrets :

- Effacer une personne d’une photo de vacances

- Altérer un décor architectural

- Coloriser une archive noir et blanc

- Modifier l’éclairage d’une scène

Le tout en quelques secondes. Avec une précision chirurgicale.

La traçabilité et la cohérence des personnages

Chaque visuel porte un filigrane invisible SynthID, garantissant sa traçabilité. Mais la prouesse majeure de Nano Banana réside ailleurs : la cohérence des personnages.

Créez un individu fictif. Déclinez-le sous différents angles. Placez-le dans d’autres contextes. Il conserve ses traits distinctifs, la forme du nez, l’expression du regard, la texture des cheveux. Un atout colossal pour les créateurs visuels ou publicitaires.

Google frappe là où tout le monde regarde : le moteur de recherche. En insérant la génération d’images au cœur des milliards de requêtes quotidiennes, l’entreprise opère un cheval de Troie culturel. Elle démocratise la création visuelle en la dissimulant dans le geste le plus banal du quotidien : faire une recherche.

La Chine libère un titan : Ling-1T et son trillion de paramètres

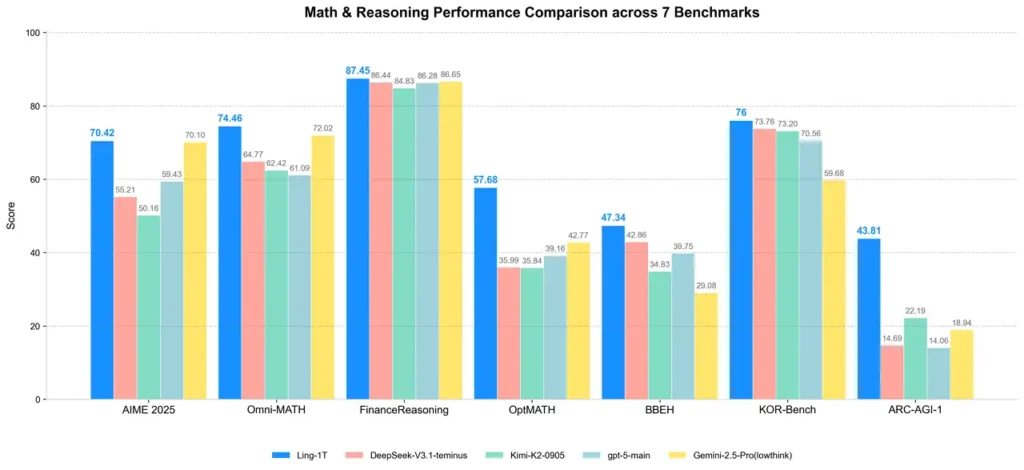

Pendant que les géants américains s’affrontent, la Chine déclenche une onde de choc d’une autre nature. Le 9 octobre, le groupe Ant (titan de la fintech à l’origine d’Alipay) dévoile Ling-1T. Un modèle linguistique d’un trillion de paramètres.

Et surtout : entièrement open source.

À une époque où les géants occidentaux ferment leurs architectures derrière des API hermétiques, cette ouverture constitue un geste de rupture radical.

Mettons les chiffres en perspective

GPT-4.5 compterait entre cinq et sept trillions de paramètres — mais reste fermé. Avec son unique trillion, Ling-1T rivalise pourtant sur les bancs d’essai avec DeepSeek, Mistral AI et les versions avancées de Gemini.

Performances notables :

- Test AIME 2025 (mathématiques) : 70,42% de précision

- Plus de 4 000 tokens de raisonnement par réponse

- Excellence en génération de code frontend

- Capacité à traduire une description en interface fonctionnelle multiplateforme

Le coup de maître réside dans la philosophie d’ouverture. Rendre le modèle libre d’accès à la communauté mondiale n’est pas qu’une décision technique. C’est une déclaration géopolitique.

L’IA comme bien commun

En libérant son modèle, la Chine promeut l’intelligence artificielle comme bien commun. Elle tisse un réseau mondial de chercheurs et développeurs capables d’enrichir collectivement la technologie. Chaque contribution renforce le cœur du système. Plus le modèle est utilisé, plus il s’affine.

Cette stratégie contraste violemment avec l’approche occidentale des modèles fermés. Elle pourrait redéfinir l’équilibre géopolitique de l’IA dans les années à venir.

Google abolit la transcription avec Speech-to-Retrieval

Début octobre, Google annonce une métamorphose du search vocal : le système Speech-to-Retrieval (S2R). Cette innovation ne se contente pas d’améliorer l’existant. Elle abolit la transcription textuelle.

Jusqu’ici, tous les assistants vocaux procédaient de la même manière :

- La voix devient texte

- Le texte devient requête

- La requête interroge la base de données

Cette étape de conversion constituait la source de la majorité des erreurs. Accents régionaux, bruits de fond, homophones — autant de pièges linguistiques.

Le paradigme vectoriel

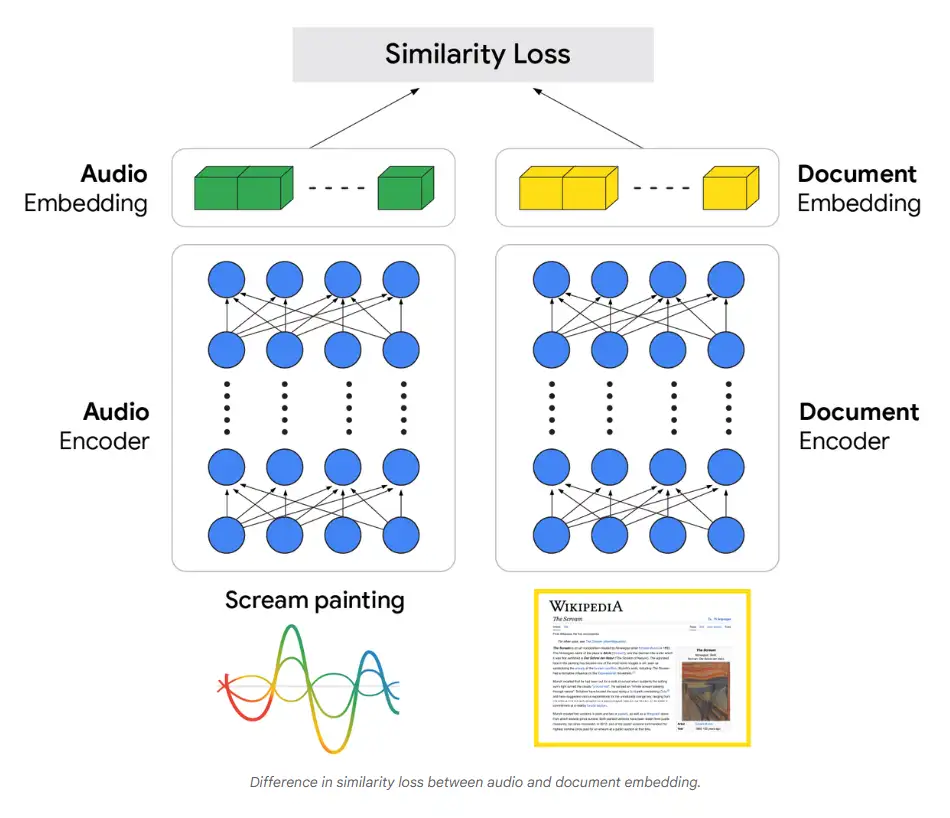

Le S2R rompt ce schéma. La voix n’est plus transformée en mots. Elle devient directement des vecteurs de sens, des représentations mathématiques de l’intention. Ces vecteurs sont comparés à ceux des milliards de documents indexés.

Plus de mots. Plus d’ambiguïté. Le sens rejoint le sens, directement.

Résultats concrets :

- Tests sur 17 langues

- Performances supérieures aux systèmes traditionnels

- Précision frôlant celle d’une transcription humaine parfaite

- Déjà actif dans la recherche vocale Google

Lorsque Google vous comprend malgré votre accent ou un fond sonore chaotique, c’est cette architecture vectorielle qui opère silencieusement.

Une nouvelle ère cognitive

Nous entrons dans une phase où l’IA cesse d’être un outil externe. Elle devient un prolongement cognitif intégré à nos flux de travail quotidiens. Chercher, créer, coder ; ces actions fusionnent dans une expérience fluide où la machine anticipe plutôt qu’elle n’exécute.

La démocratisation n’est plus un slogan marketing. Elle devient réalité tangible. Un étudiant au Cameroun accède aux mêmes capacités génératives qu’un designer à San Francisco. Un développeur en Inde exploite le même modèle qu’une startup à Berlin.

Cette convergence soulève des interrogations profondes. Comment garantir la traçabilité des contenus générés ? Les filigranes invisibles suffisent-ils face à la prolifération exponentielle d’images synthétiques ?

L’open source chinoise redistribue-t-il vraiment les cartes ? Où crée-t-il une nouvelle forme de dépendance technologique déguisée ?

Et surtout : sommes-nous prêts pour une société où la création visuelle devient aussi banale que taper une requête ?

Ces révolutions ne vous demandent pas la permission. Elles s’installent dans vos outils préférés. Elles transforment vos habitudes. Elles redéfinissent ce qui est possible.

La seule question pertinente n’est plus « si » vous utiliserez ces technologies. C’est « comment » vous les intégrerez pour amplifier votre créativité, votre productivité et votre impact.

L’avenir n’attend pas. Il se construit maintenant, une requête vocale à la fois, une image générée à la fois, un modèle libéré à la fois.

Testez les différents modèles sur https://lmarena.ai/